2025-10-31

Innovation Highlights

弋力团队构建了一个关注双人合作重新摆放家用物体的大规模的融合真实和合成数据的人-物-人交互数据集CORE4D。该数据集结合了真实世界中的光-惯混合动作捕捉和仿真环境中全新的合作重定向算法,提出了动作预测和动作生成的基准任务,检验了现有方法并发现它们面临的挑战。CORE4D能提升现有的动作预测方法的效果,并支持人形机器人交互技能的学习。

Achievements Summary

一个关于合作式物体重摆放的人-物-人交互数据集:CORE4D

分析和生成多人协作搬运家具的动作在虚拟现实、增强现实、人机合作和灵巧手操作等领域中有重要应用。然而囿于缺乏相关数据,迄今为止这些方法并未得到广泛研究。为填补数据的缺失,弋力团队构建了一个大规模类别级的融合真实和合成数据的人-物-人交互数据集—CORE4D。CORE4D关注双人合作重摆放家用物体的行为,共计包含4种合作模式、6种物体类别、约3K种物体形状和约11K段交互动作。

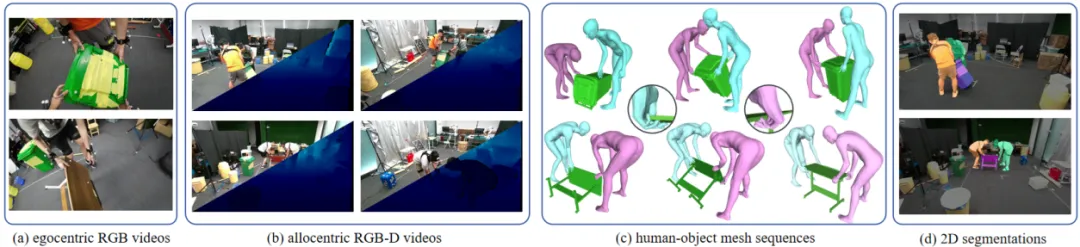

图. CORE4D数据集由真实数据(CORE4D-Real)和合成数据(CORE4D-Synthetic)组成

为收集这些大规模的交互数据,现有的基于视觉的动作捕捉方案难以处理频繁出现的遮挡情况,而光学/光-惯混合的方法成本高昂。对此,团队提出了一个混合的数据获取方法,综合了真实世界中的光-惯混合动作捕捉和仿真环境中的新的合作重定向算法,由此收集了真实数据集CORE4D-Real和合成数据集COR4D-Synthetic。在CORE4D-Real中,每段合作动作的数据包含4个第三人称视角下的彩色视频和深度视频、一个第一人称视角下的彩色视频、由动作捕捉系统采集的人-物-人网格序列和第三人称视角下的掩码视频。合作重定向算法将CORE4D-Real的合作动作重定向到大量新的物体形状上形成CORE4D-Synthetic。

图. CORE4D-Real数据模态

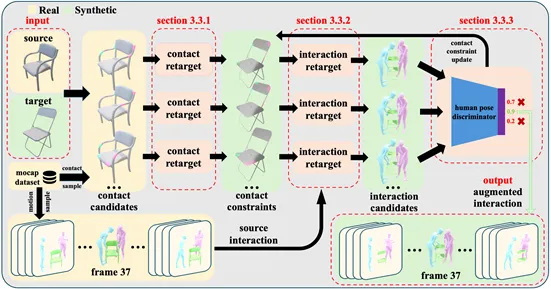

图. 合作重定向算法

CORE4D为人-物-人合作动作的理解和生成带来的新的研究机遇。团队在CORE4D数据集上提出了两个新的基准任务——动作预测和动作生成,测试了现有方法的表现并汇报了它们面临的挑战。此外,定量实验和用户试验验证了本文的合作重定向算法生成动作具有更高的自然性和物理真实性。

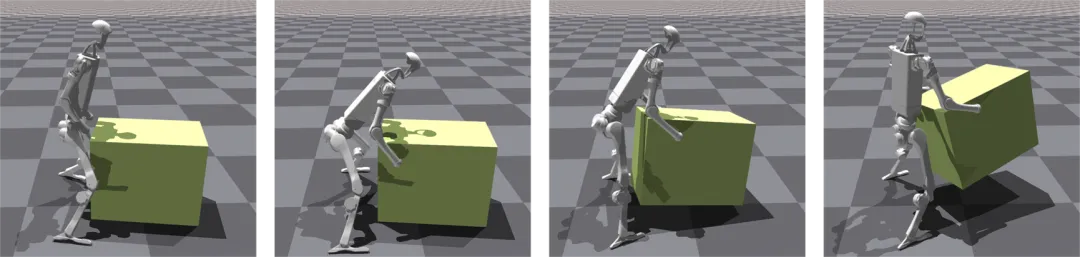

团队证实了CORE4D的两项应用:CORE4D-Synthetic能提升现有的动作预测方法的效果。更重要的是,CORE4D能够支持人形机器人交互技能的学习。

图. 人形机器人模仿CORE4D数据搬起箱子

CORE4D为多人合作的物体重摆放问题和人形机器人合作方法的研究提供了数据基础。本论文共同第一作者为上海期智研究院实习生、清华大学博士生刘昀和北京邮电大学章成文,通讯作者为研究院PI、清华大学助理教授弋力。共同作者为美国东北大学幸若凡,清华大学汤秉达、杨博文。

论文信息:

CORE4D: A 4D Human-Object-Human Interaction Dataset for Collaborative Object REarrangement, Yun Liu*, Chengwen Zhang*, Ruofan Xing, Bingda Tang, Bowen Yang, Li Yi†, https://core4d.github.io/, CVPR 2025.