2024-01-15

得益于大量数据集和基准任务的提出,如何在图片、视频和点云中感知物体和人类活动这一问题已经取得了显著的成果。但是,随着机器人行业的快速发展和元宇宙的兴起,仅对上述数据类型进行感知已经无法满足行业的需求。机器人和VR/AR设备可以产生大量的4D数据(第一人称下的彩色点云序列),AI系统需要从中理解语义信息、手和物体的位姿信息、物体的功能性以及人手动作的类别等,这都是非常具有挑战性的开放问题。弋力团队提出了第一个大规模第一人称类别级人-物体交互4D数据集HOI4D。 数据集包括了4个采集者采集的4000段点云视频(总计2.4M帧点云), 16个类别总计800个物体实例。

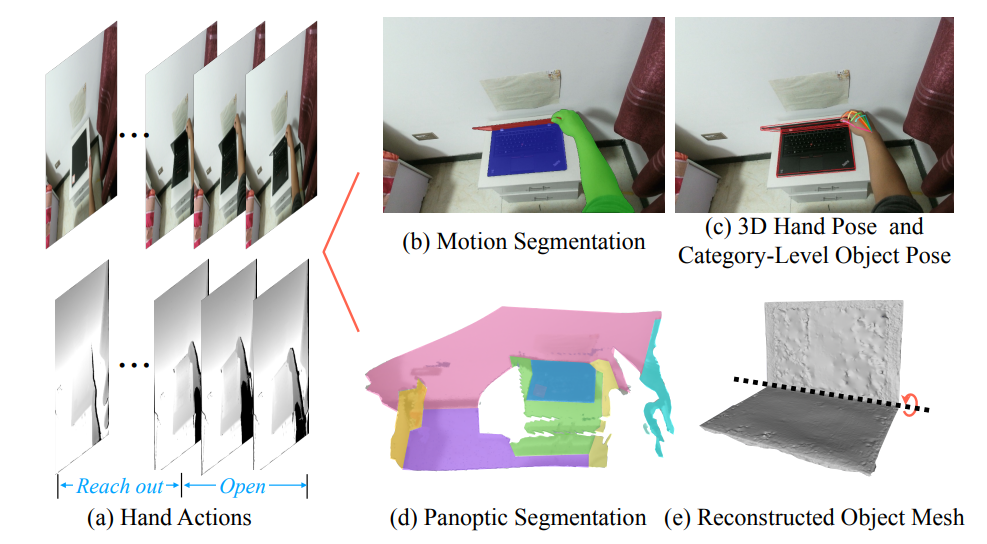

HOI4D数据集提供了用于全景分割、运动分割、3D手部位姿、类别级物体位姿和手部动作的逐帧注释,以及物体CAD模型和重建场景点云。该工作还建立了三个基准任务来促进4D类别级人-物体交互的发展,包括4D动态点云序列的语义分割、类别级物体位姿跟踪和第一人称的细粒度视频动作分割。此研究可以支持大量的新兴研究方向,如4D场景理解、类别级人-物体交互、动态场景重建等,对人-物体交互领域的发展具有重要推动作用。

分享到