2025-11-03

Innovation Highlights

姚远团队提出了RLAIF-V—完全使用开源多模态大模型反馈信号,通过分治算法自动构造高质量偏好数据,以提升多模态大模型可信度。团队将复杂的偏好标注任务拆解为更简单的原子命题判别任务,从而使得基于开源模型自动构造的偏好数据质量得到显著提升,达到与人工精标注结果超过90%的一致性,超过蒸馏 GPT-4V 等模型的偏好标注质量。通过在训练和测试时充分挖掘和利用开源自动偏好实现了超越GPT-4V的模型可信度,并提出了开源多模态大模型通过自学习提升可信度的新范式。

Achievements Summary

RLAIF-V: 基于开源AI反馈实现超过GPT-4V可信度

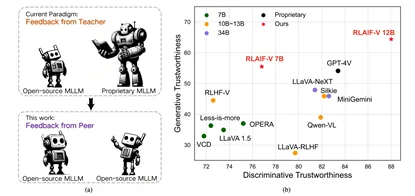

图(左)RLAIF-V代表的从蒸馏模仿商用模型到高效学习同级别开源模型反馈的新偏好学习范式,(右)在生成和判别任务中的可信度评估结果

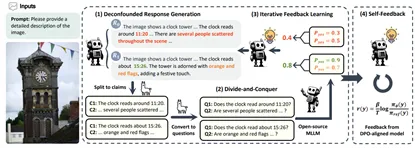

多模态大模型的最新成果代表了人工智能发展的一个重要里程碑,这些模型展现出了丰富的世界知识和多样的任务解决能力。然而,学术界和工业界都普遍发现多模态大模型容易生成与图像内容无关的反事实内容,影响了多模态大模型的可信度与可用性。为了解决这一问题,传统方法依赖劳动密集型的人工标注或蒸馏昂贵的闭源模型以获得偏好学习数据。这导致开源社区缺乏关于如何利用开源多模态大模型,构建高质量偏好数据的基础性知识。姚远团队提出的RLAIF-V,作为一种能够在完全开源范式下对多模态大模型进行偏好数据构造和学习的高效框架,从训练阶段和推理阶段两个方面最大化地利用了开源多模态大模型的能力。在6个基准测试上进行的自动化和人工评测实验结果表明,RLAIF-V在训练和推理阶段都大幅提升了模型的可信度。

图15. RLAIF-V数据构造及模型训练框架. HiRT通过层次化变压器模型来解决大模型推理慢的问题

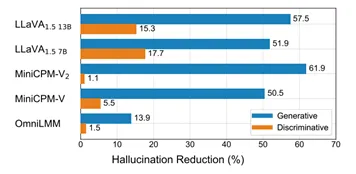

姚远团队进一步分析RLAIF-V框架生成的偏好学习数据的泛化性,并验证发现用单个开源多模态大模型构造的偏好数据可以在众多常见多模态大模型上实现显著的可信度提升。

图. RLAIF-V 12B偏好数据显著提升其他多模态大模型可信度

RLAIF-V为可信多模态大模型构建提供了全新的思路,揭示了多模态大模型自学习提升可信度这一范式的可行性。获得谷歌学术引用120次,成为多模态大模型可信行为研究领域的重要基础工作之一,登上国际开源平台HuggingFace Dataset Trending榜单首页。相关成果收录于CVPR 2025中并获选 Highlight论文。本论文一作为清华大学博士生余天予,通讯作者为期智研究院PI姚远。

论文信息:

RLAIF-V: Open-Source AI Feedback Leads to Super GPT-4V Trustworthiness, Tianyu Yu, Haoye Zhang, Qiming Li, Qixin Xu, Yuan Yao, Da Chen, Xiaoman Lu, Ganqu Cui, Yunkai Dang, Taiwen He, Xiaocheng Feng, Jun Song, Bo Zheng, Zhiyuan Liu, Tat-Seng Chua, Maosong Sun, https://github.com/RLHF-V/RLAIF-V, CVPR 2025.

分享到